L’A/B testing compare deux versions d’une interface pour identifier celle qui génère le plus de conversions. Cette méthode simple mais puissante s’appuie sur des données réelles pour ajuster messages, design et fonctionnalités sans prise de risque. En optimisant chaque élément testé, vous augmentez l’engagement utilisateur et améliorez durablement vos performances digitales. Découvrez comment exploiter au mieux cette technique incontournable.

Introduction à l’A/B Testing : définissez, comprenez et optimisez

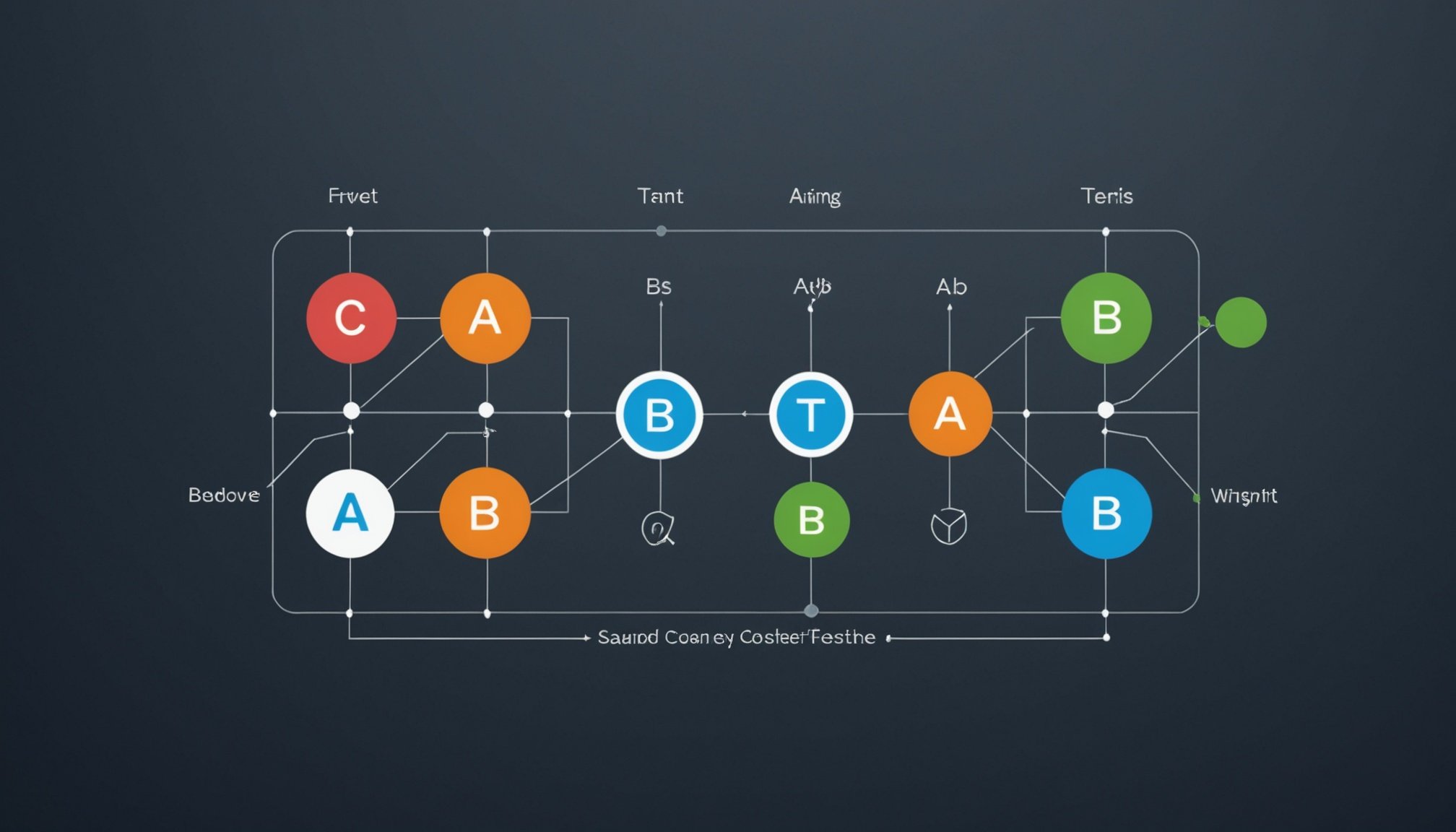

Le ab testing est une méthode analytique qui compare deux versions d’une même interface, permettant d’évaluer leur performance. Dans le marketing et l’UX, il joue un rôle clé dans la prise de décisions data-driven. En divisant aléatoirement les utilisateurs entre deux variantes, cette technique fournit des résultats précis pour optimiser le taux de conversion.

A lire aussi : Augmentez votre présence en ligne en investissant dans des abonnés !

Les bénéfices incluent une augmentation des conversions et une réduction des hypothèses subjectives. Par exemple, tester différentes couleurs de CTA ou phrases accrocheuses permet d’améliorer l’engagement. La méthode suit une procédure structurée : définition d’objectifs, formulation d’hypothèses, distribution du trafic, test prolongé, puis analyse statistique.

Les outils populaires, tels que Google Optimize ou Adobe, facilitent la mise en œuvre. En somme, l’ab testing permet d’expérimenter en toute sécurité, en suivant des principes fondamentaux précis, pour une meilleure compréhension de l’interaction utilisateur et une optimisation continue.

Dans le meme genre : Les bases indispensables pour réussir sa première pub Google Ads

Méthodologie et processus d’A/B Testing

Définition claire des objectifs et identification des éléments testés

L’efficacité du processus A/B testing repose sur une planification rigoureuse. Avant tout, il s’agit de formuler des hypothèses précises : “Changer la couleur du bouton augmenterait-il le taux de conversion ?” Sélectionnez les éléments stratégiques à modifier, tels que titres, call-to-action, pages de destination ou contenus d’emails marketing. Cette étape permet de cadrer l’expérimentation et d’assurer que chaque variante testée répond bien à l’objectif initial.

Conception des variantes et segmentation des audiences

La conception d’expériences utilisateurs pertinentes implique d’élaborer des variantes distinctes pour chaque hypothèse, tout en segmentant l’audience selon les comportements ou données démographiques. Par exemple, un test comparatif en marketing peut opposer deux formulations sur une même bannière auprès des nouveaux visiteurs uniquement. Segmenter ainsi les audiences maximise la pertinence de l’analyse statistique pour tests et isole l’impact de chaque variable testée.

Analyse statistique et interprétation des résultats

Après mise en œuvre, la phase d’analyse statistique pour tests détermine la fiabilité des résultats. L’usage d’outils pour tests A/B permet de calculer la significativité statistique et d’éviter les biais dans tests. Interpréter les résultats exige une lecture attentive : un taux de conversion avant-après n’est concluant qu’avec une taille d’échantillon adéquate. L’analyse de résultats statistiques guide ensuite toutes décisions d’optimisation taux de conversion.

Outils, meilleures pratiques et erreurs à éviter

Les outils A/B modernes sont indispensables pour réaliser des tests comparatifs en marketing efficaces et fiables. Parmi les plateformes les plus utilisées, Google Optimize se distingue par son intégration facile avec Google Analytics et son accessibilité, idéale pour initier des tests sur pages de destination, emails marketing ou applications mobiles. Les solutions comme Adobe permettent des analyses statistiques avancées, une segmentation d’audience fine, et s’adaptent à des stratégies multiplateformes (e-commerce, campagnes publicitaires, tests pour optimisation CRO). D’autres outils gratuits pour tests conviennent à des expérimentations ponctuelles, tandis que les plateformes test A/B Shopify séduisent les boutiques en ligne grâce à une automatisation et un suivi conversion détaillé.

Pour structurer un test multivarié, la durée optimale d’un test dépend du trafic web et de la taille d’échantillon, mais il est recommandé de viser au minimum 1 000 visiteurs par variante. Respecter la méthodologie test hypothèse, segmenter les utilisateurs selon leur comportement, et planifier chaque étape évite les pièges communs : mauvaise segmentation avancée, tests arrêtés trop tôt, erreurs de type I et II, ou biais dans tests. Ainsi, en suivant ces meilleures pratiques pour tests, on s’assure d’une analyse de résultats statistiques fiable et utile à l’évolution des taux de conversion.

A/B Testing : Méthodologie et Processus Pour L’Optimisation du Taux de Conversion

Le A/B testing consiste à soumettre deux versions d’un même élément à des échantillons aléatoires d’utilisateurs et à mesurer leur impact pour optimiser le taux de conversion. La démarche statistique, centrale en analyse statistique pour tests, favorise des décisions data-driven : on définit l’objectif de l’expérience, puis on procède à une répartition équitable du trafic web entre la version de référence (A) et la variante (B).

Cette méthodologie débute par la formulation d’une hypothèse marketing : par exemple, tester la couleur d’un bouton “acheter” pour voir l’effet sur le taux de clic. On utilise des outils pour tests A/B — gratuits ou payants — permettant un suivi des conversions avec tests depuis l’implémentation, jusqu’à l’analyse post-campagne. La durée optimale d’un test dépend de la taille d’échantillon adéquate : un minimum de 1 000 visites par variante augmente la probabilité de statistiques significatives.

Les plateformes test A/B Shopify et les guides pratiques tels que le Google Optimize guide aident à la conception d’expériences utilisateurs robustes, segmentant l’audience pour révéler l’impact des variables indépendantes sur la conversion. La segmentation d’audience, selon le comportement utilisateur ou la démographie, affine ainsi l’interprétation des données test.